Una historia… que podría ser la vuestra

Imagina que tu empresa acaba de invertir una suma considerable en una nueva solución de IA empresarial. El objetivo es revolucionar el servicio al cliente con un chatbot impulsado por un LLM (Large Language Model). En las primeras semanas, todo parece funcionar a la perfección. El bot responde con una fluidez asombrosa, entiende preguntas complejas y parece destinado a ayudar…

Pero entonces, ocurre. Un cliente importante pregunta por la política de devoluciones de un producto específico y el bot, con una confianza absoluta, inventa una política nueva que no existe. El bot le ofrece un reembolso completo y un vale de descuento, una promesa que tu empresa ahora debe cumplir, con el consiguiente coste financiero y de reputación.

Este fenómeno, conocido como alucinaciones de IA, no es un fallo aislado; es una característica de los LLMs estándar y representa el mayor obstáculo para su adopción empresarial a gran escala. Estos modelos, entrenados con la inmensidad caótica de Internet, son increíblemente creativos, pero no tienen una conexión con la realidad fáctica de tu negocio.

Para los directivos, CTOs y líderes de innovación, esto presenta un dilema crítico: ¿cómo aprovechar el poder transformador de los LLMs sin exponer a la empresa a los riesgos de la desinformación, la pérdida de confianza y las decisiones estratégicas basadas en datos falsos?

La respuesta no está en limitar la IA, sino en hacerla más inteligente y fiable. La solución es una tecnología innovadora llamada Generación Aumentada por Recuperación (RAG). Este no es solo un avance técnico; es un imperativo estratégico que convierte a los LLMs de genios creativos pero poco fiables en activos empresariales precisos, seguros y de alto rendimiento.

El gran dilema: genios creativos con puntos ciegos

Para entender la genialidad de RAG, primero debemos apreciar la naturaleza de los LLMs. Modelos como GPT-5 y otros similares son maravillas de la probabilidad estadística. Han sido entrenados para predecir la siguiente palabra más lógica en una secuencia, basándose en los patrones que han aprendido de miles de millones de textos, desde artículos científicos hasta publicaciones en redes sociales.

Esta capacidad les permite redactar correos electrónicos, resumir documentos y generar código con una habilidad asombrosa. Sin embargo, su fortaleza es también su debilidad fundamental. No saben nada en el sentido humano; no tienen conciencia de la verdad. Simplemente calculan lo que suena plausible.

Una alucinación de IA ocurre cuando esa predicción plausible se desvía hacia la invención. El LLM, al no encontrar una respuesta fáctica en sus datos de entrenamiento o al conectar patrones incorrectos, «rellena los huecos» con información inventada que parece coherente.

Los riesgos empresariales de las alucionaciones

Para un líder empresarial, las implicaciones son enormes:

- Desinformación al Cliente: Un chatbot que inventa características de un producto o políticas de la empresa daña la confianza del cliente de forma inmediata.

- Decisiones Estratégicas Erróneas: Si un analista utiliza un LLM para resumir informes de mercado y el modelo alucina una tendencia inexistente, podría llevar a una toma de decisiones con IA desastrosa y a una asignación de recursos equivocada.

- Riesgos Legales y de Cumplimiento: En sectores regulados como el financiero o el sanitario, una IA que genere información incorrecta puede tener graves consecuencias legales.

- Erosión de la Confianza Interna: Si los empleados no pueden confiar en las herramientas de IA que se les proporcionan, la adopción fracasará y la inversión se perderá.

El problema no es que los LLMs sean inútiles, sino que operan en un vacío de contexto empresarial específico. Para que sean verdaderamente valiosos, necesitan una fuente de verdad. Necesitan un RAG.

RAG: Anclando la IA en la realidad de vuestra empresa

Entonces, ¿qué es exactamente la Generación Aumentada por Recuperación?

Piensa en un LLM estándar como un consultor brillante que ha leído casi todos los libros del mundo, pero que trabaja de memoria. Si le preguntas algo específico sobre tu empresa, intentará recordar algo similar que haya leído, pero si no lo encuentra, improvisará para no quedar mal contigo.

Las técnicas RAG les da a ese mismo consultor un superpoder: acceso instantáneo y obligatorio a la biblioteca interna completa y verificada de tu empresa (tus documentos, bases de datos, manuales de producto, informes financieros, etc.). Y lo que es más importante, le obliga a basar cada respuesta en los documentos que encuentre en esa biblioteca.

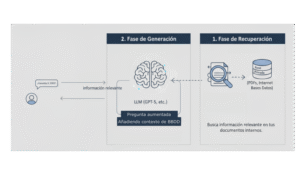

El proceso es elegante y potente, y se desarrolla en dos fases clave:

- Fase de Recuperación (Retrieval): Cuando un usuario hace una pregunta (por ejemplo, «¿Cuáles son los términos de garantía para el modelo X-2000?»), el sistema RAG no envía inmediatamente la pregunta al LLM. Primero, utiliza algoritmos de búsqueda semántica para escanear tu base de conocimiento privada y segura (la «biblioteca» de la empresa). Encuentra los fragmentos de texto más relevantes: el manual del producto X-2000, las políticas de garantía actualizadas, etc.

- Fase de Generación (Generation): A continuación, el sistema «aumenta» la pregunta original del usuario con la información precisa que acaba de recuperar. Le pasa al LLM una instrucción mucho más específica, como: «Basándote en los siguientes textos [aquí se inserta el texto exacto de la política de garantía], responde a la pregunta: ‘¿Cuáles son los términos de garantía para el modelo X-2000?'».

El resultado es una transformación total. El LLM ya no está adivinando. Está sintetizando información a partir de una fuente de verdad controlada, proporcionando una respuesta que no solo es fluida y coherente, sino también precisa y verificable. Esto es fundamental para lograr una precisión LLM de nivel empresarial.

Beneficios Estratégicos: Más Allá de la Mitigación de Alucinaciones

La implementación RAG va mucho más allá de ser un simple «corrector de hechos». Es una estrategia que desbloquea un valor empresarial tangible y multifacético.

Seguridad de Datos IA de Nivel Fort Knox

Una de las mayores preocupaciones para los CTOs es la seguridad de los datos. Entrenar o reajustar (fine-tuning) un LLM con datos corporativos sensibles puede ser arriesgado, ya que esa información podría filtrarse en respuestas a otros usuarios.

RAG resuelve este problema de raíz. Tus datos propietarios nunca se utilizan para entrenar el modelo base. Permanecen seguros en tu propia infraestructura. El sistema RAG los recupera «justo a tiempo» para responder a una consulta específica, actuando como un intermediario seguro que protege tu activo más valioso: la información. Esto garantiza una seguridad de datos IA robusta.

Gestión de Conocimiento IA y una Única Fuente de Verdad

Toda empresa tiene «conocimiento oscuro«: información valiosa atrapada en PDFs, correos electrónicos, intranets obsoletas y bases de datos dispares. RAG es la clave para iluminar ese conocimiento.

Al indexar estas fuentes de datos en una base de conocimiento para RAG, creas de facto una única fuente de verdad inteligente y conversacional. Cualquier empleado, desde un nuevo contratado hasta el CEO, puede hacer preguntas en lenguaje natural y obtener respuestas instantáneas y precisas, extraídas directamente de los documentos corporativos oficiales.

Reducción Drástica de Costes y Tiempos

El reentrenamiento o el ajuste fino de un LLM es un proceso computacionalmente intensivo, caro y lento. Si tu política de precios cambia, ¿realmente quieres volver a entrenar un modelo de esta envergadura?

Con RAG, la actualización es sencilla y casi instantánea. Simplemente actualiza el documento en tu base de conocimientos. El sistema RAG comenzará a utilizar la nueva información de inmediato. Esta agilidad reduce drásticamente los costes de mantenimiento y permite que tu IA evolucione a la misma velocidad que tu negocio.

Personalización IA y Relevancia Contextual

RAG permite un nivel de personalización que los LLMs genéricos no pueden llegar. Al conectar el sistema a bases de datos de clientes (de forma segura), un chatbot de RAG puede proporcionar respuestas que tengan en cuenta el historial de compras de un cliente, su nivel de servicio o sus interacciones previas. Esta capacidad de **personalización IA** crea experiencias de cliente mucho más ricas y efectivas, impulsando la lealtad y las ventas.

Casos prácticos

La teoría es convincente, pero los casos de uso RAG demuestran su impacto en el mundo real:

- Soporte al Cliente de Próxima Generación: Empresas de software, comercio electrónico y telecomunicaciones están utilizando RAG para potenciar chatbots que resuelven el 90% de las consultas basándose estrictamente en manuales de usuario y bases de conocimiento internas, liberando a los agentes humanos para problemas de alto nivel.

- Asistentes de Investigación para Equipos Legales y Financieros: Bufetes de abogados y departamentos financieros utilizan RAG para interrogar instantáneamente miles de páginas de contratos, regulaciones y informes financieros, extrayendo cláusulas clave o identificando riesgos en segundos en lugar de días.

- Onboarding y Formación de Empleados Acelerada: Departamentos de RRHH implementan sistemas RAG donde los nuevos empleados pueden preguntar cualquier cosa, desde «¿Cómo configuro mi VPN?» hasta «¿Cuáles son nuestros valores corporativos?», y recibir respuestas instantáneas basadas en la documentación oficial.

- Optimización de la Cadena de Suministro: Los gerentes de logística pueden consultar un sistema RAG para preguntar: «Dados los retrasos actuales en el puerto de Singapur y nuestro inventario actual, ¿cuál es la ruta óptima para el envío 74-B?». El sistema recupera datos en tiempo real y documentación de procesos para dar una recomendación informada.

Estos ejemplos ilustran un cambio fundamental: de usar la IA como un juguete creativo a implementarla como una herramienta empresarial estratégica para una toma de decisiones con IA más rápida e inteligente.

¿Estás listo para dejar de preocuparte por las alucinaciones y empezar a construir una IA en la que puedas confiar para hacer crecer tu negocio?

Contacta con nuestro equipo de expertos hoy mismo para una consulta estratégica. Descubre cómo una implementación RAG personalizada puede anclar tu IA en la realidad y desbloquear su verdadero potencial. ¡Contáctanos!